これまでの授業では、カメラの使い方、画像処理、輪郭抽出など「古典的な画像処理」を学びました。

いよいよ、「機械学習(Machine Learning)」を使った物体認識に挑戦します。

機械学習とは?

人がルールを書く → コンピュータが学ぶへ

前回までは、人間があらかじめ

- 「明るさが100より大きい→白」

- 「頂点数が3→三角形」

といったルールをプログラムとして書いていました。

一方、機械学習では

| 従来の手法 | 機械学習 |

|---|---|

| 人間がルールを書く | コンピュータがデータからルールを学ぶ |

| 特定の条件に強い | 複雑な画像・多様な背景にも対応可能 |

つまり、犬や猫の画像をたくさん見せて「自分で特徴を見つけて分類できるようになる」のが機械学習です。

以下に、機械学習で良く扱う専門用の解説をしておきます。

| 用語 | やさしい説明 |

|---|---|

| データセット | 学習に使う大量の例(例:猫画像100枚、犬画像100枚) |

| 特徴量(Feature) | データの特徴を数値で表したもの(画像ならピクセルやエッジなど) |

| モデル(Model) | 学習によって得られた「分類の仕組み」 |

| 学習(Training) | データからモデルを作ること |

| 推論(Inference) | 学習済みモデルで新しい画像を分類すること |

| クラス分類 | 「これは○○です」と分類する処理 |

機械学習を体験

機械学習は以下のような流れで推論を行います。

データ集め → モデルを学習 → モデル保存

↓

新しい画像 → 推論(分類) → 結果

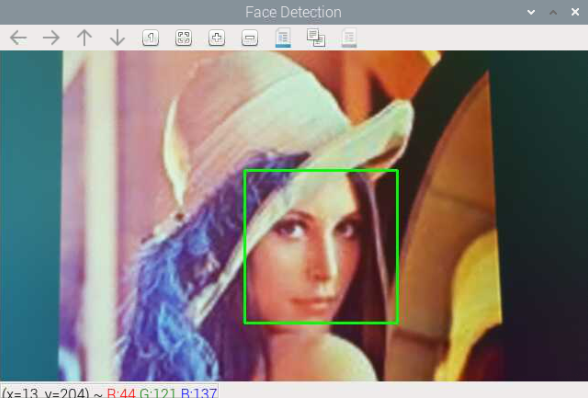

しかし、ゼロからモデルを作るのは時間がかかるので、今回は OpenCV に付属する「学習済みモデル(Haar Cascade)」を使います。

これは顔や目などを素早く検出できる古典的な機械学習モデルです。

ライブラリをインストールします。

ターミナルで以下のコマンドを実行してください。

sudo apt update

sudo apt install -y libopencv-dev opencv-data以下の顔認識のサンプルコードを実行してみてください

# 顔検出(Haar Cascade)

# Picamera2 + OpenCV

from picamera2 import Picamera2

import cv2, time

# Haar Cascade(学習済み分類器)のパス

cascade_path = "/usr/share/opencv4/haarcascades/haarcascade_frontalface_default.xml"

face_cascade = cv2.CascadeClassifier(cascade_path)

# カメラ初期化(640×360)

cam = Picamera2()

cam.configure(cam.create_preview_configuration(main={"size": (640, 360)}))

cam.start(); time.sleep(0.2)

# フル視野を使用(デジタルズーム防止)

try:

sw, sh = cam.camera_properties["PixelArraySize"]

cam.set_controls({"ScalerCrop": (0, 0, int(sw), int(sh))})

except:

cam.set_controls({"ScalerCrop": (0, 0, 2592, 1944)})

while True:

# 画像取得 → BGR → Gray

frame = cv2.cvtColor(cam.capture_array(), cv2.COLOR_RGB2BGR)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 顔検出(複数OK)

faces = face_cascade.detectMultiScale(

gray,

scaleFactor=1.2, # 小さいほど精度↑/計算↑

minNeighbors=5, # 誤検出を抑える(大きいほど厳しい)

minSize=(30, 30) # 最小サイズ(遠くの顔→小さく)

)

# 顔の枠を描画

for (x, y, w, h) in faces:

cv2.rectangle(frame, (x, y), (x+w, y+h), (0,255,0), 2)

cv2.imshow("Face Detection", frame)

# q で終了

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows(); cam.stop()コードのポイント

| 処理 | 内容 |

|---|---|

CascadeClassifier | 顔検出用モデル(学習済みXML)を読み込む |

detectMultiScale | 画像内の顔の位置を自動検出する関数 |

scaleFactor | 顔の大きさを変えながら探索する倍率(1.05〜1.3程度) |

minNeighbors | 誤検出を減らすパラメータ(大きいほど厳しい) |

minSize | 検出対象の最小サイズ(距離によって調整) |

rectangle | 検出した領域を緑の四角で表示 |

問題10

プログラムを実行し、顔が検出されることを確認しよう。複数人で写るとどうなるかも試してみましょう。

観察ポイント:

- 明るさや角度によって検出精度が変わる

scaleFactorとminNeighborsを調整すると検出数が変わる

問題11

複数の顔が映ったとき、それぞれに Face 1, Face 2 のようなラベルを付けて表示してみましょう。

ヒント:

for i, (x, y, w, h) in enumerate(faces):

cv2.rectangle(bgr, (x, y), (x+w, y+h), (0, 255, 0), 2)

cv2.putText(bgr, f"Face {i+1}", (x, y-10),

cv2.FONT_HERSHEY_SIMPLEX, 0.7, (255, 0, 0), 2)解答例はこちら

# 複数顔を検出して番号付け表示(Haar Cascade)

# Picamera2 + OpenCV

from picamera2 import Picamera2

import cv2, time

# 学習済み分類器(正面顔)

cascade_path = "/usr/share/opencv4/haarcascades/haarcascade_frontalface_default.xml"

face_cascade = cv2.CascadeClassifier(cascade_path)

# カメラ初期化(640x360)

cam = Picamera2()

cam.configure(cam.create_preview_configuration(main={"size": (640, 360)}))

cam.start(); time.sleep(0.2) # 起動安定

# フル視野を使用(デジタルズーム防止)

try:

sw, sh = cam.camera_properties["PixelArraySize"]

cam.set_controls({"ScalerCrop": (0, 0, int(sw), int(sh))})

except:

cam.set_controls({"ScalerCrop": (0, 0, 2592, 1944)})

while True:

# 取得→BGR→Gray

frame = cv2.cvtColor(cam.capture_array(), cv2.COLOR_RGB2BGR)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 顔検出(複数対応)

faces = face_cascade.detectMultiScale(

gray, scaleFactor=1.2, minNeighbors=5, minSize=(30, 30)

)

# 顔に番号ラベルを描画

for i, (x, y, w, h) in enumerate(faces, start=1):

cv2.rectangle(frame, (x, y), (x+w, y+h), (0,255,0), 2) # 顔枠

cv2.putText(frame, f"Face {i}", (x, max(0, y-8)), # 番号

cv2.FONT_HERSHEY_SIMPLEX, 0.7, (255,0,0), 2)

# 総数を表示

cv2.putText(frame, f"Detected: {len(faces)}",

(10, 28), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0,255,255), 2)

cv2.imshow("Face Numbering", frame)

# qで終了

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows(); cam.stop()| 処理 | 内容 |

|---|---|

enumerate(faces) | 検出した顔リストをインデックス付きで繰り返し処理できる |

label = f"Face {i+1}" | 0から始まる番号に+1して、人間が見やすい番号にする |

cv2.putText() | 検出した顔の矩形の上に番号ラベルを描画する |

こうすることで、複数人が同時に映っていても「どの枠が誰のものか」を区別できます。

特に複数人を同時に認識して動作するロボットを作るときに必須のテクニックです

問題12

OpenCV には顔以外にも様々なHaarモデルがあります。

ほかのモデルを使ったプログラムを作成し、動作を確かめてください。

| モデルファイル | 検出対象 |

|---|---|

haarcascade_eye.xml | 目 |

haarcascade_smile.xml | 笑顔 |

haarcascade_fullbody.xml | 全身 |

解答例はこちら

解答例①:顔と目を同時に検出

# 顔+目検出(Haar Cascade)

# Picamera2 + OpenCV

from picamera2 import Picamera2

import cv2, time

# 学習済み分類器(正面顔・目)

face_cascade = cv2.CascadeClassifier("/usr/share/opencv4/haarcascades/haarcascade_frontalface_default.xml")

eye_cascade = cv2.CascadeClassifier("/usr/share/opencv4/haarcascades/haarcascade_eye.xml")

# カメラ初期化(640x360)

cam = Picamera2()

cam.configure(cam.create_preview_configuration(main={"size": (640, 360)}))

cam.start(); time.sleep(0.2) # 起動安定待ち

# フル視野を使用(デジタルズーム防止)

try:

sw, sh = cam.camera_properties["PixelArraySize"]

cam.set_controls({"ScalerCrop": (0, 0, int(sw), int(sh))})

except:

cam.set_controls({"ScalerCrop": (0, 0, 2592, 1944)})

while True:

# 取得→BGR→Gray

frame = cv2.cvtColor(cam.capture_array(), cv2.COLOR_RGB2BGR)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 顔検出(複数対応)

faces = face_cascade.detectMultiScale(gray, scaleFactor=1.2, minNeighbors=5, minSize=(30, 30))

for (x, y, w, h) in faces:

# 顔枠

cv2.rectangle(frame, (x, y), (x+w, y+h), (0,255,0), 2)

# 顔領域で目検出(誤検出抑制)

roi_gray = gray[y:y+h, x:x+w]

roi_color = frame[y:y+h, x:x+w]

eyes = eye_cascade.detectMultiScale(roi_gray, scaleFactor=1.2, minNeighbors=10, minSize=(15, 15))

# 目枠

for (ex, ey, ew, eh) in eyes:

cv2.rectangle(roi_color, (ex, ey), (ex+ew, ey+eh), (255,0,0), 2)

cv2.putText(frame, f"Faces: {len(faces)}", (10, 28), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0,255,255), 2)

cv2.imshow("Face + Eyes", frame)

# qで終了

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows(); cam.stop()| 処理 | 内容 |

|---|---|

roi_gray = gray[y:y+h, x:x+w] | 顔領域を切り出して、その中だけで目を検出 |

eye_cascade.detectMultiScale() | 目の位置を検出(誤検出を防ぐため顔の中だけで処理) |

rectangle | 顔は緑、目は青で描画して区別 |

解答例②:笑顔(スマイル)検出

# 笑顔検出(顔→笑顔の順にHaar Cascadeで検出)

# Picamera2 + OpenCV

from picamera2 import Picamera2

import cv2, time

# 分類器(正面顔・笑顔)

face_cascade = cv2.CascadeClassifier("/usr/share/opencv4/haarcascades/haarcascade_frontalface_default.xml")

smile_cascade = cv2.CascadeClassifier("/usr/share/opencv4/haarcascades/haarcascade_smile.xml")

# カメラ初期化(640x360)

cam = Picamera2()

cam.configure(cam.create_preview_configuration(main={"size": (640, 360)}))

cam.start(); time.sleep(0.2)

# フル視野を使用(デジタルズーム防止)

try:

sw, sh = cam.camera_properties["PixelArraySize"]

cam.set_controls({"ScalerCrop": (0, 0, int(sw), int(sh))})

except:

cam.set_controls({"ScalerCrop": (0, 0, 2592, 1944)})

while True:

# 取得 → BGR → Gray

frame = cv2.cvtColor(cam.capture_array(), cv2.COLOR_RGB2BGR)

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 顔検出(誤検出抑制にminNeighborsを適度に)

faces = face_cascade.detectMultiScale(gray, scaleFactor=1.2, minNeighbors=5, minSize=(30, 30))

smile_count = 0

for (x, y, w, h) in faces:

# 顔枠

cv2.rectangle(frame, (x, y), (x+w, y+h), (0,255,0), 2)

# 顔領域で笑顔検出(スケール・近傍はやや厳しめ)

roi_gray = gray[y:y+h, x:x+w]

roi_color = frame[y:y+h, x:x+w]

smiles = smile_cascade.detectMultiScale(

roi_gray, scaleFactor=1.8, minNeighbors=20, minSize=(25, 25)

)

# 笑顔枠

for (sx, sy, sw, sh) in smiles:

cv2.rectangle(roi_color, (sx, sy), (sx+sw, sy+sh), (0,0,255), 2)

if len(smiles) > 0:

smile_count += 1

# カウンタ表示(検出顔数/笑顔の顔数)

cv2.putText(frame, f"Faces: {len(faces)} Smiling: {smile_count}",

(10, 28), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0,255,255), 2)

cv2.imshow("Smile Detection", frame)

# qで終了

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows(); cam.stop()Haar の笑顔検出モデルはやや誤検出が多いため、

scaleFactorを 1.7〜1.9minNeighborsを 15〜25

にすると安定します。

実際に笑顔になると、口元に赤い四角が表示されます

次回はこちら